728x90

1. Model Compression (모델 경량화)

- 목적

- On-device AI

- AI on cloud

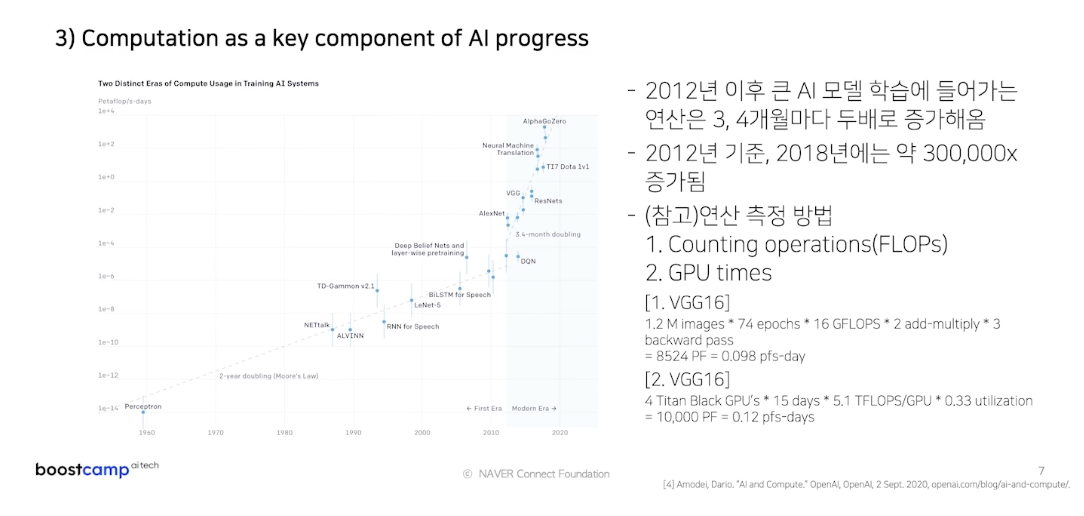

- Computation

- 경량화

- 모델의 연구와는 별개로, 산업에 적용되기 위해서 거쳐야하는 과정

- 요구조건(하드웨어 종류, latency 제한, 요구 throughput, 성능)들 간의 trade-off를 고려하여 모델 경량화/최적화를 수행

- 경량화, 최적화의 대표적인 종류

- 네트워크 구조 관점

- Efficient architecture design : 경량화에 특화된 모델을 설계

- Network Pruning : 중요도가 낮은 파라미터를 제거

- Knowledge Distillation : 학습된 큰 네트워크를 작은 네트워크의 학습 보조로 사용

- Matrix/Tensor Decomposition : 하나의 Tensor를 다른 tensor들의 operation으로 표현

- Hardware 관점

- Network Quantization : Data type 연산과정 -> 그보다 작은 Data type으로 변환 후 연산

- Network Compiling : 속도에 가장 큰 영향을 미침

- 네트워크 구조 관점

- 과정

- 경량 모델 탐색 : AutoML

- 찾은 모델 쪼개기 : Tensor Decomposition

- 쪼갠 모델 꾸겨넣기 : Quantization &Complie

728x90